Guiada para o bem

PUBLICAÇÃO

quarta-feira, 21 de junho de 2017

Mie Francine Chiba<br>Reportagem Local

Imagine um robô com Inteligência Artificial (IA) desenvolvido com o objetivo de proteger o meio ambiente. A partir de informações, uma IA é capaz de tomar suas próprias decisões baseadas no seu aprendizado. E se o robô chega à conclusão de que o maior inimigo do meio ambiente é o homem? A situação hipotética, lançada pelo advogado especializado em Direito Digital Fernando Peres, traduz o medo de muitos quando o assunto é Inteligência Artificial.

Em uma Conferência realizada pela ONU (Organização das Nações Unidas), em Genebra, sobre os benefícios da IA, o secretário-geral da Anistia Internacional, Salil Shetty, falou sobre a necessidade de um "marco ético claro" para garantir que a tecnologia seja usada para o bem de todos. "Precisamos estabelecer princípios, precisamos de um equilíbrio entre os poderes", disse à AFP, alertando que a inteligência artificial é "uma caixa preta (...). Estão sendo escritos algoritmos que ninguém entende".

"Muita gente subestima a necessidade de discutir essa questão", diz Fernando Peres, também membro da IAAIL (International Association for Artificial Intelligence and Law - Associação Internacional para a Inteligência Artificial e o Direito). No último Campus Party, ele fez uma apresentação sobre "O Direito do Robô". Para Peres, muitas pessoas consideram a IA algo reservado a um futuro muito distante, quando, na verdade, ela já é real. "Infelizmente, o Direito nunca acompanha as nossas necessidades. O ideal é prever algumas situações porque, quando acontecerem, não haverá mais tempo de discuti-las." O advogado alerta para a necessidade de haver, pelo menos, a discussão de uma base teórica para uma lei de Inteligência Artificial para que, quando alguma situação envolvendo a tecnologia ocorrer, já seja possível tomar uma decisão sobre ela.

Interpretações

Segundo explica Peres, a Inteligência Artificial toma decisões baseada em algoritmos e comandos, mas também em dados que obtém de diversas fontes. Com esses dados em mãos, ela realiza interpretações e toma decisões de acordo com o aprendizado que obteve desse processo. "Vão surgir situações em que a máquina pode até mesmo mudar o seu rumo, mas não o comando. É uma máquina dotada de inteligência que tem autonomia e capacidade de aprendizado."

Ele lembra que o Parlamento Europeu já realiza estudos sobre normas para a robótica no Direito Civil Europeu. "Cada país vai ter um entendimento diferente (sobre IA). O ideal é que houvesse um tratado entre países para regulamentar todas essas questões, pois a tecnologia é muito unificada, globalizada." Peres afirma que, nesse estudo, já se discute a figura de uma "pessoa eletrônica" para a Inteligência Artificial. "Tem que ter uma personalidade jurídica para ser responsabilizada (em casos de crimes)." Também é preciso analisar se o crime foi cometido por falha do fabricante ou por comando, por exemplo. "Mas quando falamos de IA, temos que pensar a possibilidade de ela ter tomado sua própria decisão."

Também é preciso ponderar sobre o direito à privacidade, já que, na visão de Peres, a Inteligência Artificial, assim como os objetos conectados, fazem com que as pessoas percam cada vez mais a sua liberdade.

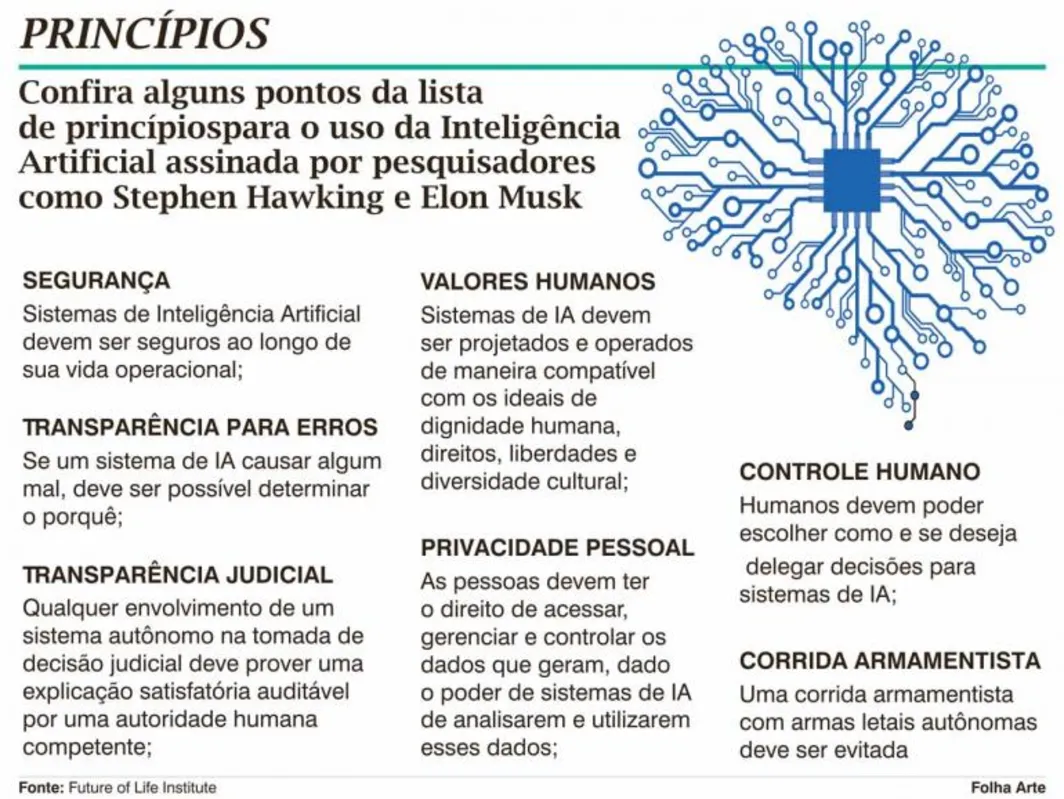

Princípios éticos

Neste ano, figuras como o físico Stephen Hawking e Elon Musk, CEO da SpaceX - companhia de tecnologia espacial com projetos audaciosos como colonizar outros planetas -, expressaram o apoio a uma lista de 23 princípios que devem guiar o desenvolvimento da Inteligência Artificial a fim de que ela seja benéfica para a humanidade. A lista foi feita pelo Instituto Futuro da Vida (Future of Life Institute), uma entidade sem fins lucrativos que tem como cofundadores o fundador do Skype, Jaan Tallin, e o ator Morgan Freeman. A lista inclui pontos como a segurança, valores, privacidade e controle sobre a Inteligência Artificial (veja no infográfico).

Para o advogado Fernando Peres, "é certo que deve haver um limite (para a IA)". Por isso, é preciso "prever agora até onde se quer chegar no futuro para criar regras de conduta para desenvolvedores", conclui o advogado. "Não podemos subestimar nossa capacidade de criar tecnologias inteligentes."

Regulamentação sim, mas sem frear avanços

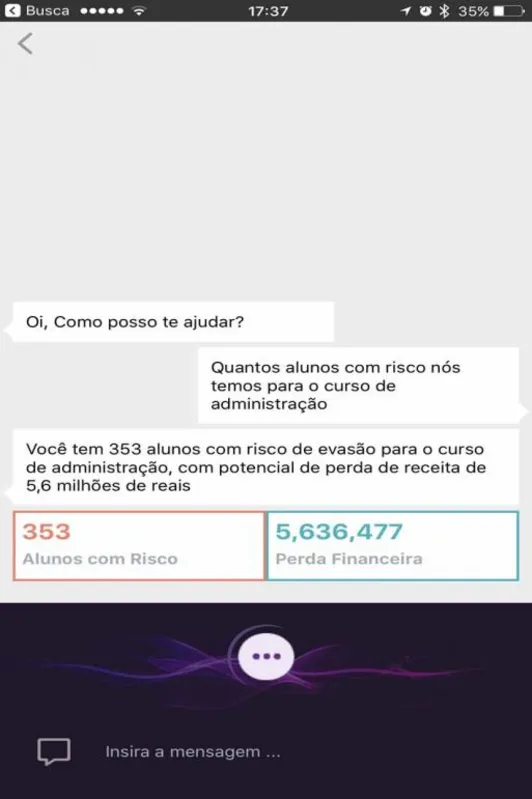

"Você dá para a máquina vários algoritmos e ela começa a selecionar e combiná-los. No final, você não sabe que algoritmo foi usado. Isso já acontece hoje com a gente e começamos a ver algumas correlações bem assustadoras. A gente viu já coisas que são 'mindblowing' (algo inimaginável), que um humano, com nossa capacidade limitada de olhar para dados, não conseguiria achar." O relato é de Vicente Goetten, diretor executivo da TOTVS Labs, que apresentou na semana passada, em São Paulo, Carol, sua plataforma de dados e Inteligência Artificial.

Carol ainda não toma decisões, nem as executa sozinha, mas o diretor executivo diz que esse será seu caminho natural. "A gente está deixando nas mãos dos nossos clientes (tomar decisões) por enquanto, mas acho que a evolução natural é que para alguns processos a máquina comece a tomar o lugar do humano." Ele se refere a processos "menos perigosos", como aprovação de crédito ou ordem de produção.

Privacidade

Um dos diferenciais da Carol, entretanto, é que ela "não é tão caixa-preta". "Ela te mostra o 'o quê' e o 'porquê', e te recomenda o que fazer." Carol também é à prova de violação de privacidade. Segundo ele, os dados que a plataforma utiliza não são compartilhados com outros clientes e isso já está previsto no código do programa. "O que existe é o compartilhamento da inteligência", ele ressalta. Goetten explica que Carol foi desenvolvida no conceito de "multitenância", com forte isolamento entre os "tenants" (clientes). "A gente não consegue de forma alguma acessar informações de um outro cliente. Isso já está no código, é inquebrável hoje."

Regulamentação

Dado o potencial da IA, Goetten defende uma regulamentação da tecnologia envolvendo empreendedores, sociedade e governo, mas com ressalvas. "Eu sou contra você frear a inovação e a tecnologia. Claro que existem segmentos como saúde que pode ter impacto grande dependendo do uso de IA. Acho que o bom senso, talvez ter um core de boas práticas, regular sem limitar muito a evolução da tecnologia, seja o caminho."

'Treinamento' de IA é supervisionado

Para alcançar seus objetivos de maneira mais rápida, a Inteligência Artificial é "treinada" de maneira supervisionada, nunca livre. Isso é o que afirma Lúcio de Oliveira, diretor de Operações da Nama, empresa brasileira desenvolvedora de chatbots (robôs de conversação) que utilizam linguagem natural capazes de conversar com um ser humano sem a necessidade de protocolos de conversação. "É questão de ética e também de valor", explica Oliveira. Segundo ele, robôs precisam ter treinamento supervisionado e serem movidos a regras de negócio para que o seu entendimento evolua e ele consiga cumprir o seu papel mais rapidamente.

As pessoas costumam pensar no lado negativo da tecnologia quando, na verdade, a "IA tem um valor muito grande que é possível utilizar em benefício das pessoas", comenta Oliveira. Um dos exemplos é a aplicação da Inteligência Artificial em processos em que os humanos são ineficientes, diz. "A IA vem para eliminar alguns tipos de trabalhos humanos e levar as pessoas a fazerem coisas com geração de valor mais relevantes." Mesmo assim, para o diretor de Operações, um marco ético é importante para que a tecnologia não seja usada para o mal e também para garantir a privacidade das pessoas. "A tecnologia é poderosa e pode ser utilizada de maneira errônea por pessoas para aplicações que não tragam o bem."(M.F.C.)